Облачные сервисы по детекту и фильтрации трафика: Стоит ли слепо доверять? - «Надо знать»

- 20:14, 16-июл-2020

- Новости

- Hancock

- 0

Стоит ли повторяться что каждый надёжный нетворк стремится к повышению эффективности трафика и что на этом держится вся индустрия? Количество подобных дискуссий уже и так предостаточно.

В этой же статье мы хотели затронуть тему облачных решений по верификации и фильтрации бот-трафика. Стоит ли им верить, и насколько они надёжны в предоставлении данных?

Выбор тезиса не был случаен, так как мы получили своеобразный вызов от одного из наших партнёров и решили проверить всё это на практике.

Этап 1 (сравнение)

Для начала решили сравнить уникальность трафика в сравнении с такими же крупными сетями.

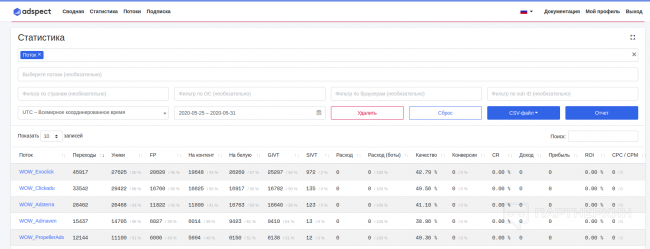

Выбрали оффер на Францию (FR), установили закупку по средним рейтам и наблюдали через Adspect.

Результаты, которые мы получили:

Как читать показатели?

Система делит трафика на потенциальных лендинга.

“Правильный” трафик попадает на основной контент. “Неправильный” - на отдельный “белый” лендинг. Нас интересовало как раз три этих столбца: количество трафика, которое отсеивалось и показатели качества.

Резюмирование #1:

Можно было бы на этом остановиться и подвести итог, что показатели уникальности Clickadu выше, чем в других нетворках. Но суть проверки была не в этом, не в том чтобы доказать что качества трафа выше конкурентов.

Суть - проверить алгоритм отбора трафика и определить его эффективность и валидность его показателей.

Этап II (проверка “белых”)

Нас, как нетворк который предоставляет трафик с прямых площадок, не удовлетворили эти цифры.

Так что целью второго теста было проверить, есть ли конверсии на отфильтрованном трафике с "белых страниц", и как отличается CR по сравнению с не отфильтрованным трафиком на основном ленде.

В качестве оффера во втором тесте использовались наши пуш подписки, одинаковые для основной и белой страницы.

Мы отлили на оффер такой же трафик с теми же настройками. В результате мы получили слишком мало конверсий, чтобы что-то сравнить.

Тогда мы решили взять Android IN трафик, чтобы сравнить CR "белой" и основной страниц только для этого трафика.

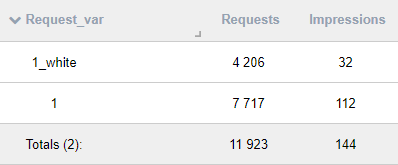

Результаты, которые мы получили:

Как читать показатели?

1_white - белая страница

1 - основная страница.

Impressions в данном случае = количество конверсий. Таким образом высчитываем CR:

"Правильный" (1) = 0,0145% CR

"Нерпавильный" (1_white) = 0,0078% CR

Резюмирование #2:

Итоговые показатели CR в подписчика на "белой" странице в 2 раза хуже, чем на основной и это ожидаемый результат. Но трафик все еще конвертит.

Итоги

Для начала, хотелось бы заявить что мы не выступаем против подобных решений и Adspect в частности. Даже наоборот, хорошо когда у каждого арбитражника есть возможность проверить качество и уникальность трафика путём подобных решений.

Вопрос состоит в качестве подобных решений, их алгоритмов и предоставляемых ими данных. До конца не известен принцип фильтрации на "белую" страницу, и подобные решения не могут поделиться критериями проверки качества трафика.

Ответ на наш запрос оказался весьма небрежным и не объективным. Данный случай списали на проблему VLA решения и излишней бережливости алгоритма проверки.

Однако, команда обратила внимание на это только после нашего фидбэка с тестами трафика.

Руководствоваться подобными решениями при тесте трафика или нет - дело каждого.

Если вы хотите, чтобы мы пошли дальше с тестами подобных решений - ждём ваших комментариев.

Комментарии (0)