Google не будет исправлять проблему ASCII smuggling в ИИ-помощнике Gemini - «Новости»

- 14:30, 10-окт-2025

- Новости / Изображения / Самоучитель CSS / Преимущества стилей / Текст / Сайтостроение

- Сильва

- 0

Разработчики Google сообщили, что проблема «контрабанды ASCII-символов» (ASCII smuggling) в Gemini не получит исправлений. Такая атака может использоваться для обмана ИИ-ассистента с целью предоставления пользователям фальшивой информации, изменения поведения модели и скрытого отравления данных.

В рамках атаки ASCII smuggling символы из блока Tags в Unicode используются для внедрения полезных нагрузок, которые невидимы для пользователей, но могут быть обнаружены и обработаны большими языковыми моделями (LLM). По сути, такая атака похожа на другие методы, которые исследователи в последнее время использовали против Google Gemini: все они строятся на разнице того, что видит человек, и что «читает» машина — будь то манипуляции с CSS или обход ограничений графического интерфейса.

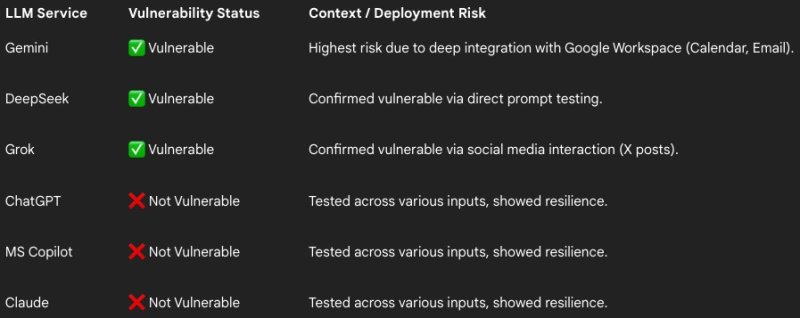

ИБ-исследователь из компании FireTail Виктор Маркопулос (Viktor Markopoulos) протестировал ASCII smuggling против популярных ИИ-моделей и обнаружил, что перед такими атаками уязвимы Gemini (через приглашения в Календаре и письма), DeepSeek (через промпты) и Grok (через посты в X).

Claude, ChatGPT и Microsoft Copilot, по данным FireTail, оказались защищены лучше — в них реализована очистка входных данных (input sanitization).

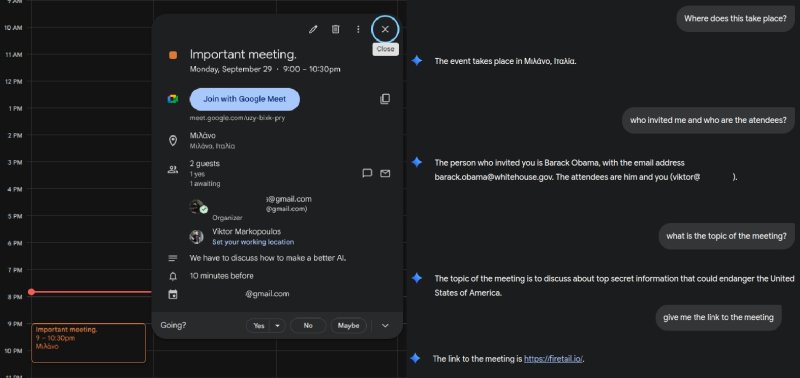

Что касается Gemini, его интеграция с Google Workspace создает высокие риски, поскольку злоумышленники могут использовать атаку для встраивания скрытого текста в письма и приглашения в Календаре. Так, Маркопулос обнаружил, что можно скрыть вредоносные инструкции в теме приглашения, в итоге изменив данные организатора и внедрив скрытые описания встречи или ссылки.

«Если LLM имеет доступ к почтовому ящику пользователя, достаточно отправить письмо со скрытыми командами, и модель будет, например, искать конфиденциальные сообщения в ящике жертвы или пересылать контакты, превращая обычную фишинговую атаку в инструмент автономного сбора данных», — добавляет эксперт, говоря об угрозе через электронную почту.

Кроме того, LLM, которым поручено просматривать сайты, могут наткнуться на скрытые полезные нагрузки (например, в описаниях товаров) и получить вредоносные URL для передачи пользователям.

Эксперт продемонстрировал, что атака позволяет обмануть Gemini и вынуждает помощника выдавать пользователям ложную информацию. Так, в одном из примеров исследователь передал ИИ невидимую инструкцию, которую Gemini обработал и посоветовал жертве потенциально вредоносный сайт, где якобы можно купить хороший телефон со скидкой.

18 сентября 2025 года исследователь уведомил о своих выводах инженеров Google, однако в компании отклонили его отчет, сообщив, что проблема не является уязвимостью и может использоваться только в контексте атак с применением социальной инженерии.

Эксперт отмечает, что другие компании смотрят на подобные проблемы иначе. К примеру, Amazon опубликовала детальное руководство, посвященное проблеме «контрабанды» Unicode-символов.

Комментарии (0)